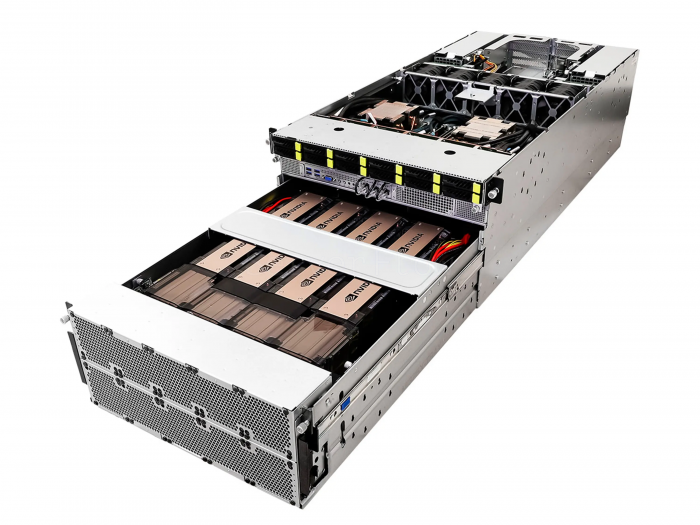

ASRock Rack 6U8X-EGS2 H100 (8× H100 SXM 80GB)

Цена с учетом расширенной гарантии

Цена включает НДС 7%

Узнать сроки доставки

40-60 раб. дней —

перед отправкой

| Тип | Новые |

| Основная задача | Обучение моделей / Инференс / Дообучение моделей / RAG-системы / Анализ данных / Научные расчеты (HPC) |

| Процессор (CPU) | Intel Xeon |

| Видеокарта (GPU) | NVIDIA H100 |

| Количество GPU, шт | 8 |

| Общий объем видеопамяти (VRAM), ГБ | 640 |

| Тип памяти GPU | HBM3 |

| Объем оперативной памяти (RAM), ГБ | 8192 |

| Тип оперативной памяти | DDR5 ECC REG |

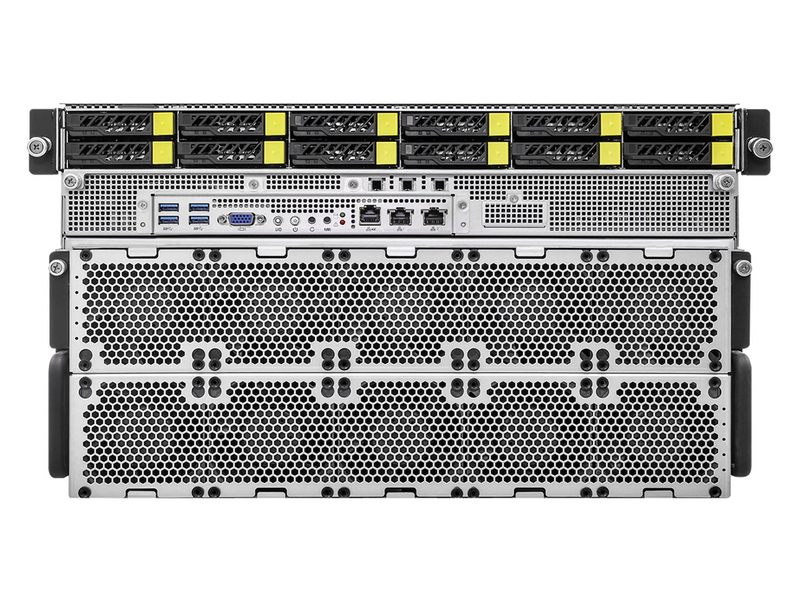

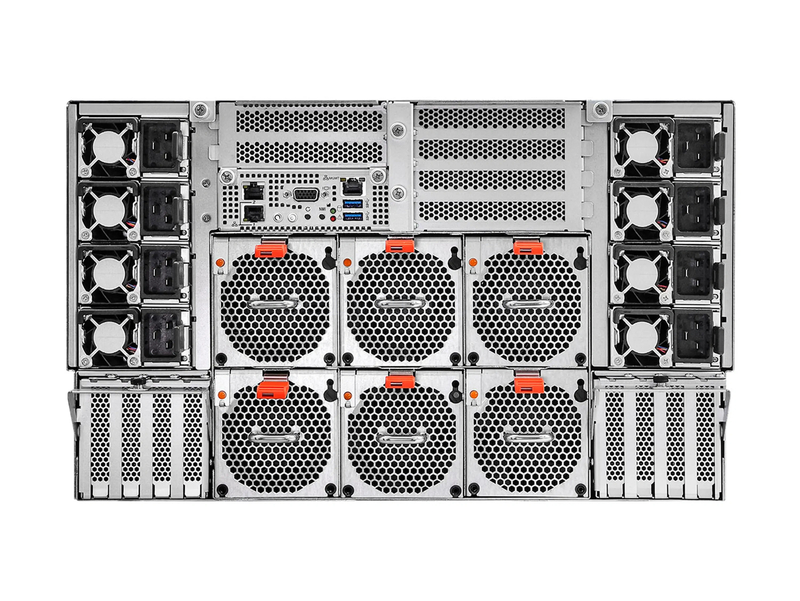

| Форм-фактор | 6U |

Конфигурация рассчитана на Обучение моделей (Training), Дообучение моделей (Fine-tuning) и Инференс / Развертывание (Inference), когда важны стабильная работа на 8 GPU и высокий throughput в продакшне. Также хорошо подходит под RAG-системы (Retrieval-Augmented Generation) и HPC / Научные расчёты за счёт плотной связности ускорителей внутри HGX.

Узел построен на NVIDIA HGX H100 8-GPU с NVSwitch, в этой сборке используется 8× H100 SXM 80GB, суммарно 640GB VRAM. Это позволяет держать большие батчи и длинный контекст, а ускорение FP16/FP8/INT8 помогает масштабировать как обучение, так и serving.

Для предсказуемой нагрузки обычно выигрывает распределение по 4–8 GPU и аккуратные лимиты по контексту и батчу, чтобы оставлять запас под KV-cache и служебный оверхед при высоком параллелизме.

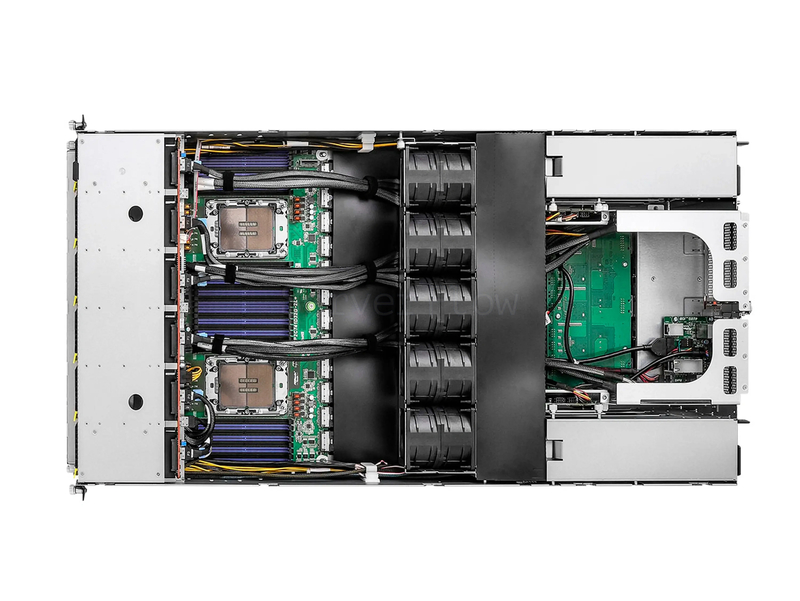

Платформа поддерживает два процессора Intel Xeon Scalable 4th и 5th Gen в сокетах LGA 4677. Для памяти предусмотрено 32 DIMM слота (16+16, 2DPC) с поддержкой DDR5 RDIMM и RDIMM-3DS, при этом максимальный объём - до . Для накопителей доступны 8 hot-swap 2.5" NVMe (PCIe 5.0 x4) и 4 hot-swap 2.5" NVMe (PCIe 5.0 x4) или SATA, плюс 2 слота M.2 (PCIe 3.0 x4, один также поддерживает SATA 6Gb/s).

Производительность GPU

| Тип точности | Совокупная мощность восьми H100 SXM |

| FP64 Tensor Core | 536 TFLOPS |

| FP8 Tensor Core | 31 664 TFLOPS |

| BF16 / FP16 Tensor Core | 15 832TFLOPS |

| TF32 Tensor Core | 7 912 TFLOPS |

| INT8 Tensor Core | 31 664 TOPS |

Совместимость с LLM-моделями

| Модель | Тип квантизации | Требуется VRAM | Совместимость | Примечание |

| DeepSeek-R1-GGUF 685B | Q4_K_M | Примерно 404GB | ✅ | Лучше запускать с tensor parallel на 8 GPU и умеренным контекстом, чтобы оставить запас под KV-cache. |

| Qwen3-235B-A22B-Instruct | Нет | Примерно 471GB | ✅ | Запускается без квантизации на 8 GPU, можно повышать батчи и параллельные запросы с запасом VRAM. |

| Gpt-oss:120b | Нет | Примерно 196GB | ✅ | Комфортно на 2–4 GPU с большим запасом под длинные диалоги и высокий QPS. |

| ai-sage_GigaChat3-702B-A36B-preview-GGUF | Q4_K_M | Примерно 472GB | ✅ | Оптимально распределять по 4–8 GPU и держать разумный контекст, чтобы не упираться в KV-cache на пике. |

| Mistral-Large-3-675B-Instruct-2512-GGUF | Q4_K_M | Примерно 407GB | ✅ | Хорошо масштабируется на 4–8 GPU, запас VRAM лучше держать под контекст и рост batch size. |

| GLM-4.7-GGUF | Q4_K_M | Примерно 216GB | ✅ | Стабильный продакшн запуск на 2–4 GPU с запасом VRAM под параллельные сессии. |

Совместимость с диффузионными моделями

| Модель | Тип | Совместимость | Примечание |

| Stable Diffusion XL 1.0 | Текст в изображение | ✅ | Можно держать высокие разрешения и несколько пайплайнов параллельно на разных GPU. |

| Flux.2-dev | Текст в изображение | ⚠️ | Обычно нужен multi-GPU режим или оптимизации памяти, затем throughput удобно масштабировать по 8 GPU. |

| SD Turbo | Быстрые предпросмотры | ✅ | Подходит для массовых предпросмотров с высокой параллельностью и минимальной задержкой. |

| Kandinsky-5.0-T2I-Lite-sft-Diffusers | Текст в изображение | ✅ | Лёгкая модель, удобно запускать много параллельных задач и повышать batch. |

| Kandinsky-5.0-T2V-Lite-sft-5s-Diffusers | Текст в видео | ✅ | Пакетные короткие ролики удобно распараллеливать по GPU для стабильной очереди. |

Технические характеристики

| Видеокарта | 8x Nvidia H100 SXM 80GB HBM3 |

| Процессор | 2× Intel Xeon Scalable 4th и 5th Gen в сокетах LGA 4677 |

| Оперативная память | до 8TB DDR5 ECC RDIMM, 32 DIMM-слотах |

| SSD накопители | 8 hot-swap 2.5" NVMe (PCIe 5.0 x4) и 4 hot-swap 2.5" NVMe (PCIe 5.0 x4) или SATA, плюс 2 слота M.2 (PCIe 3.0 x4, один также поддерживает SATA 6Gb/s) |

Если нужна конфигурация на эту платформу под ваши задачи - свяжитесь с менеджером, и мы предложим подходящий вариант под бюджет и требования.

Наличие на складах (0 шт.)

Мы отправляем заказы ведущими транспортными компаниями:

- CDEK

- Деловые линии

- ПЭК

Все отправления тщательно упаковываются и скорейшие сроки передаются в ТК.

Ориентировочные сроки сборки заказов:

- Серверные комплектующие: 1-2 раб. дня.

- Серверы: 1-4 раб. дня.

- Перемещение между офисами (МСК-СПБ): 1-2 раб. дня.

В случае если оборудование требуется в срочном порядке сообщите менеджеру и мы организуем приоритетную обработку вашего заказа с учетом выбора тарифа “Экспресс” со стороны ТК.

Оплата заказа доступна после подтверждения менеджером посредством следующих способов оплаты:

- Безналичная оплата по счету (для организаций)

- Онлайн оплата банковской картой ЮКасса (SberPay, T-Pay, СБП)

ServerFlow — это интернет магазин специализирующийся на продаже Б/У и новой серверной техники. Все наше оборудование проходит строгий процесс предпродажной подготовки. Мы уделяем большое внимание тестированию всех компонентов, чтобы минимизировать вероятность возникновения гарантийных случаев и обеспечить высокое качество продукции.

Также мы можем предложить расширенный срок гарантийных отношений:

Мы верим, что сможем обеспечить наилучший пользовательский опыт и ценим ваше доверие. Если у вас остались дополнительные вопросы, вы можете адресовать их в онлайн чате на сайте или задать в Telegram @serverflow.

Подробнее об условиях гарантии ServerFlow

ServerFlow активно занимается б/у оборудованием, поэтому мы готовы рассмотреть ваше оборудование в качестве основания для предоставления скидки в рамках “Trade-in”. Чтобы произвести оценку оборудования обратитесь в онлайн чат на сайте или в Telegram @serverflow.

Почему Trade-in в ServerFlow — это удобно:

- Оперативная оценка оборудования. Оператор онлайн чата постарается в течении 30 минут дать оценку оборудованию.

- Конструктивный диалог. Если вы не согласны с предложенной стоимостью мы постараемся найти компромисс.

- Забор оборудования. После согласования Trade-in мы согласуем курьерскую доставку от двери, а если вам удобно лично посетить наш офис в Москве или Санкт-Петербурге.

- Тестирование и подтверждение скидки. Технические инженеры ServerFlow проверяет стабильность вашего оборудования. В случае подтверждения стабильности мы утвердим скидку на оборудование.

Оставьте отзыв о ServerFlow на Яндексе и условия акции будут исполнены

* скидка предоставляется при покупке от 30 000 рублей,

в ином случае предусмотрена бесплатная доставка.

Цена включает НДС 7%

Узнать сроки доставки

40-60 раб. дней —

перед отправкой

Похожие товары