Трансформеры основаны на модульной архитектуре, в которой главную роль играют:

- механизм внимания;

- самовнимание;

- энкодеры и декодеры;

- многоголовочный механизм внимания;

- нормализация и остаточные связи.

Каждый из перечисленных механизмов заслуживает подробного рассмотрения, поэтому ниже мы уделим внимание всем составляющим трансформеров в искусственном интеллекте.

Принцип работы трансформеров можно разбить на несколько последовательных этапов.

Представление входных данных

Все данные, будь то текст или изображения, преобразуются в числовую форму. Например, текстовые данные разбиваются на токены – отдельные слова, символы или их комбинации. Каждый токен затем кодируется в числовой вектор, который содержит информацию о его значении и контексте.

Поскольку трансформеры обрабатывают последовательности параллельно, они не имеют встроенного понимания порядка элементов. Для решения этой проблемы используется позиционное кодирование, которое добавляет каждому токену информацию о его позиции в последовательности.

Применение механизма самовнимания

Механизм внимания – ключевая инновация, которая лежит в основе трансформеров. Идея состоит в том, чтобы дать модели возможность «фокусироваться» на наиболее важных частях входных данных, игнорируя менее значимые. Это особенно полезно в задачах, где контекст критичен, например, в переводе текста или анализе длинных последовательностей.

Самовнимание позволяет модели анализировать, как каждый токен связан с остальными токенами в последовательности. Например, в предложении «кошка ловит мышь» модель сможет понять, что «мышь» связана с «ловит», а не с «кошка». Это достигается с помощью шагов:

- Вычисление ключей, запросов и значений. Каждому токену присваиваются три вектора, которые используются для анализа взаимосвязей.

- Сравнение элементов. Для каждого токена вычисляется степень его важности относительно других токенов.

- Взвешивание значений. Итоговый вывод для каждого токена формируется на основе взвешенной суммы всех значений в последовательности.

В результате модель точно распознает контекст введенной информации, чего нельзя добиться при последовательной обработке данных, которая используется в рекуррентных моделях. Внимание позволяет модели учитывать глобальный контекст при анализе данных, что значительно улучшает понимание сложных структур.

Многоголовочный механизм внимания

Для повышения точности анализа используются несколько «голов» внимания, каждая из которых фокусируется на различных аспектах взаимосвязей. Вот как это может функционировать:

- Входные данные делятся на части, каждая из которых обрабатывается отдельной «головой».

- Каждая голова анализирует разные аспекты: грамматические связи, контекст, зависимости.

- Итоговое представление объединяет все головы для максимальной точности.

Многоголовочный механизм внимания делает трансформеры способными захватывать гораздо больше информации из данных, чем одноголовочные механизмы.

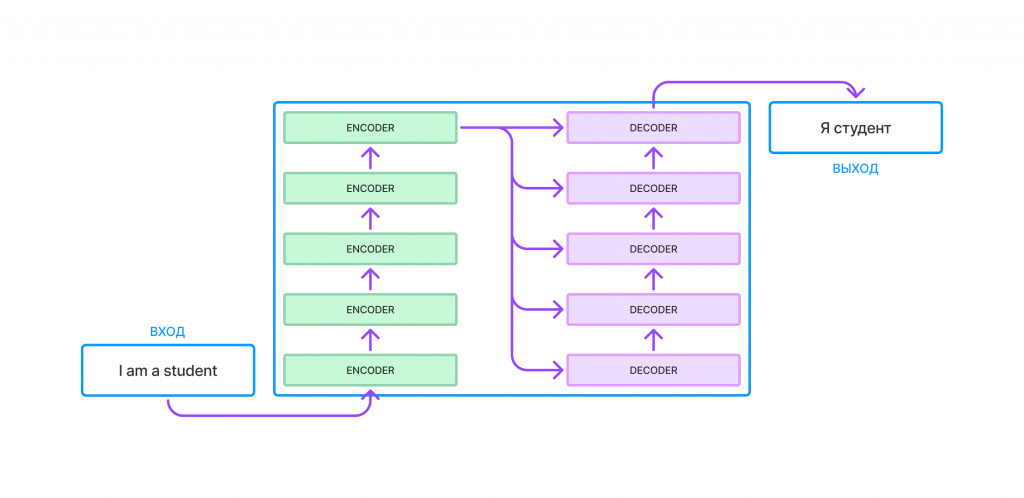

Обработка энкодерами и декодерами

Энкодеры анализируют входные данные и создают их «представление», которое содержит всю необходимую информацию.Впоследствии декодеры используют это представление для генерации выходных данных, например, перевода текста на другой язык.

В трансформере энкодеры и декодеры состоят из одинаковых блоков:

- многоголовочный механизм внимания для параллельного анализа данных;

- блок нормализации, который стабилизирует работу и ускоряет обучение;

- Feed-forward сети – они обрабатывают данные для улучшения представления.

Такая модульная структура делает трансформеры гибкими, масштабируемыми и применимыми к различным задачам.

Нормализация и остаточные связи

Для повышения стабильности и предотвращения потери данных на каждом этапе используются механизмы нормализации и остаточные связи. Они гарантируют, что информация не будет «искажена» в ходе обработки, устраняют резкие изменения в распределении данных, делая обучение стабильным. Также они улучшают сходимость моделей, снижая риск «зависания» на локальных минимумах

Кроме того, трансформеры используют остаточные связи, которые позволяют «перепрыгивать» через слои. Это предотвращает потерю информации при прохождении данных через несколько уровней внимания и нейронных сетей.

Трансформеры в современном искусственном интеллекте доказали свою универсальность, став основой для решений в самых разных областях. Их уникальная архитектура позволяет обрабатывать текст, изображения, аудио и даже сложные данные, такие как биоинформатика. Рассмотрим ключевые примеры применения трансформеров в реальном мире.

Обработка естественного языка (NLP)

Самое популярное применение трансформеров связано с задачами NLP:

- Машинный перевод. Модели, такие как BERT и T5, позволяют мгновенно переводить текст с одного языка на другой с высокой точностью, учитывая грамматику и контекст.

- Чат-боты и виртуальные помощники. GPT-3 и GPT-4 от OpenAI используются для создания интеллектуальных систем общения, таких как голосовые ассистенты или автоматизированные системы поддержки.

- Анализ текста. Трансформеры находят применение в анализе тональности, классификации текстов, автоматическом резюмировании и поисковых системах.

Именно благодаря открытию трансформеров появились крайне популярные сейчас чат-боты и сервисы, в которых любой пользователь может создавать совершенно любые виды контента.

Генерация текстов

Модели вроде GPT способны генерировать осмысленный текст по заданным параметрам. Это написание статей, сценариев, стихов и даже программного кода. Возможно создание персонализированных писем или маркетинговых материалов. Генерация текста и кода через современные нейросети с использованием трансформеров востребована как в творческих, так и в бизнес-сферах.

Обработка изображений

Хотя трансформеры изначально создавались для текста, они нашли применение в обработке визуальных данных:

- Анализ изображений. Vision Transformers (ViT) используются для классификации и сегментации изображений, обнаружения объектов.

- Генерация изображений. Технологии вроде DALL-E от OpenAI создают изображения на основе текстовых запросов, открывая новые горизонты в искусстве и дизайне.

Здесь в качестве примера можно вспомнить в том числе Midjourney, крайне популярную модель, которой в первые месяцы после появления стали пользоваться миллионы людей со всего мира.

Обработка аудио и речи

Трансформеры применяются в задачах распознавания речи и синтеза звука. Например, Whisper и аналогичные модели используют архитектуру трансформеров для точной транскрипции аудио.Кроме того, современные текстовые модели создают реалистичные синтезированные голоса, используемые в медиа и коммуникациях.

В сложных научных областях трансформеры демонстрируют свою мощь. Так, модель AlphaFold от DeepMind использует принципы трансформеров для анализа белковых последовательностей, что стало революцией в биологии. Кроме того, модели используются для анализа генома, чем помогают исследователям находить связи между генами и заболеваниями.

Другие сферы применения

Помимо перечисленных выше отраслей модели с использованием трансформеров нашли свое применение и в других сценариях использования, включая:

- Финансы. Автоматизация анализа данных, прогнозирование рыночных трендов, выявление случаев мошенничества.

- Игровая индустрия. Создание умных NPC (неигровых персонажей), адаптирующихся к стилю игрока.

- Образование. Персонализированные рекомендации по обучению, автоматическая проверка заданий, генерация учебных материалов.

Конечно, даже это не все примеры задач, в которых возможно эффективное использование ИИ с поддержкой трансформеров. Более того, спектр таких сфер постоянно расширяется благодаря эволюционному развитию самих моделей.

Трансформеры заслужили признание благодаря своим исключительным характеристикам, которые сделали их незаменимыми в задачах обработки данных. Их преимущества значительно превосходят возможности традиционных архитектур, таких как RNN и LSTM, и лежат в основе их успеха.

Высокая точность обработки данных

Механизм внимания позволяет трансформерам учитывать все зависимости в последовательности, даже если элементы находятся на большом расстоянии друг от друга. Это особенно важно в задачах, где контекст играет ключевую роль, например, в машинном переводе или анализе текстов.

Параллельная обработка данных

В отличие от рекуррентных сетей, трансформеры не требуют последовательной обработки входных данных. Это делает их значительно быстрее и позволяет эффективно использовать вычислительные ресурсы, такие как графические процессоры (GPU).

Масштабируемость

Трансформеры легко адаптируются для обучения на огромных наборах данных. Архитектура позволяет увеличивать количество слоев или голов внимания, улучшая точность и производительность модели без существенных изменений в структуре.

Гибкость и универсальность

Эти модели могут применяться для решения различных задач, включая обработку текста, изображений, аудио и других типов данных. Такая универсальность делает их незаменимыми во многих областях: от NLP до компьютерного зрения и биоинформатики.

Поддержка предобучения

Модели трансформеров, такие как GPT и BERT, могут быть обучены на больших наборах данных заранее, а затем дообучены под конкретные задачи. Это позволяет экономить ресурсы и снижать порог входа для их использования в прикладных проектах.

Способность учитывать сложный контекст

Трансформеры превосходят традиционные модели в задачах, где требуется глубокое понимание контекста. Например, они могут анализировать многозначные слова или сложные структуры предложений, правильно интерпретируя их смысл.

Адаптивность и обновляемость

Современные трансформеры легко обновляются: архитектура позволяет внедрять новые механизмы или улучшать уже существующие. Это делает их платформой для постоянных инноваций.

Поддержка многозадачности

Благодаря модульной структуре трансформеры способны решать несколько задач одновременно, например, переводить текст и анализировать тональность в рамках одной модели (мультимодальные ИИ).

Будущее трансформеров обещает быть не менее революционным, чем их настоящее. Эти модели продолжают развиваться, находя новые применения и решая задачи, которые ранее считались неподъемными.Основные направления развития:

- Улучшение энергоэффективности. Современные трансформеры требуют огромных вычислительных ресурсов, и ученые работают над оптимизацией архитектур для снижения энергозатрат.

- Модели нового поколения. Ожидается появление более мощных и универсальных трансформеров, способных обучаться на меньших объемах данных и с минимальной настройкой.

- Кросс-доменные модели. Исследования идут в сторону создания моделей, которые смогут одновременно работать с текстом, изображениями, аудио и другими типами данных.

- Углубление персонализации. Трансформеры будут адаптироваться под индивидуальные потребности пользователей, например, в образовании, медицине или искусстве.

Будущее трансформеров связано с расширением их применения, интеграцией в повседневную жизнь и дальнейшей революцией в области искусственного интеллекта.

Заключение

В качестве заключения хочется подчеркнуть, что трансформеры стали одной из самых значительных инноваций в искусственном интеллекте, изменив подход к обработке данных и решению сложных задач. Благодаря механизму внимания, самовниманию и модульной архитектуре они доказали свою универсальность и эффективность, став основой для множества современных технологий.

Их влияние простирается от обработки естественного языка до биоинформатики, а потенциал развития открывает двери для еще более амбициозных проектов. Трансформеры не просто инструменты, они символ нового этапа взаимодействия человека с машинами. В будущем мы, без сомнения, увидим еще больше их применений, которые продолжат преобразовывать наш мир.