Кастомный сервер для обучения нейросетей

- Что из себя представляет такая система

- Материнская плата под GPU

- Процессоры для работы с ИИ

- ОЗУ

- Охлаждение

- Накопители

- Видеокарты для искусственного интеллекта

- Корпус

- Переходники и адаптеры

- Питание платформы

- Дополнительные расходы

- Итоговая система

- Недостатки способа сборки

- Какую систему выбрать. Кастомную или готовую от производителя

- Вывод

Что из себя представляет такая система

Чтобы максимально повысить производительность системы, мы не используем потребительские корпуса, а переходим в концепцию ригов. Основным преимуществом ригов является высокая масштабируемость в области GPU с минимальными накладными расходами.Материнская плата под GPU:

Для работы такого рода устройства рекомендуется к установке материнская плата с обилием PCI-E 4.0 линий и гнездом для установки современных и производительных CPU.

Процессоры для работы с ИИ:

- AMD EPYC™ 7513 (32/64, 2.6GHz-3.6GHz, 200W, 128MB L3)

- AMD EPYC™ 7413 (24/48, 2.65GHz-3.6GHz, 180W, 128MB L3)

- AMD EPYC™ 7542 (32/64, 2.9GHz-3.4GHz, 225W, 128MB L3)

ОЗУ:

Охлаждение:

Поскольку в ригах нет ограничения по высоте СО, мы установим тихую 4U систему охлаждения с запасом по TDP

Накопители:

Видеокарты для искусственного интеллекта:

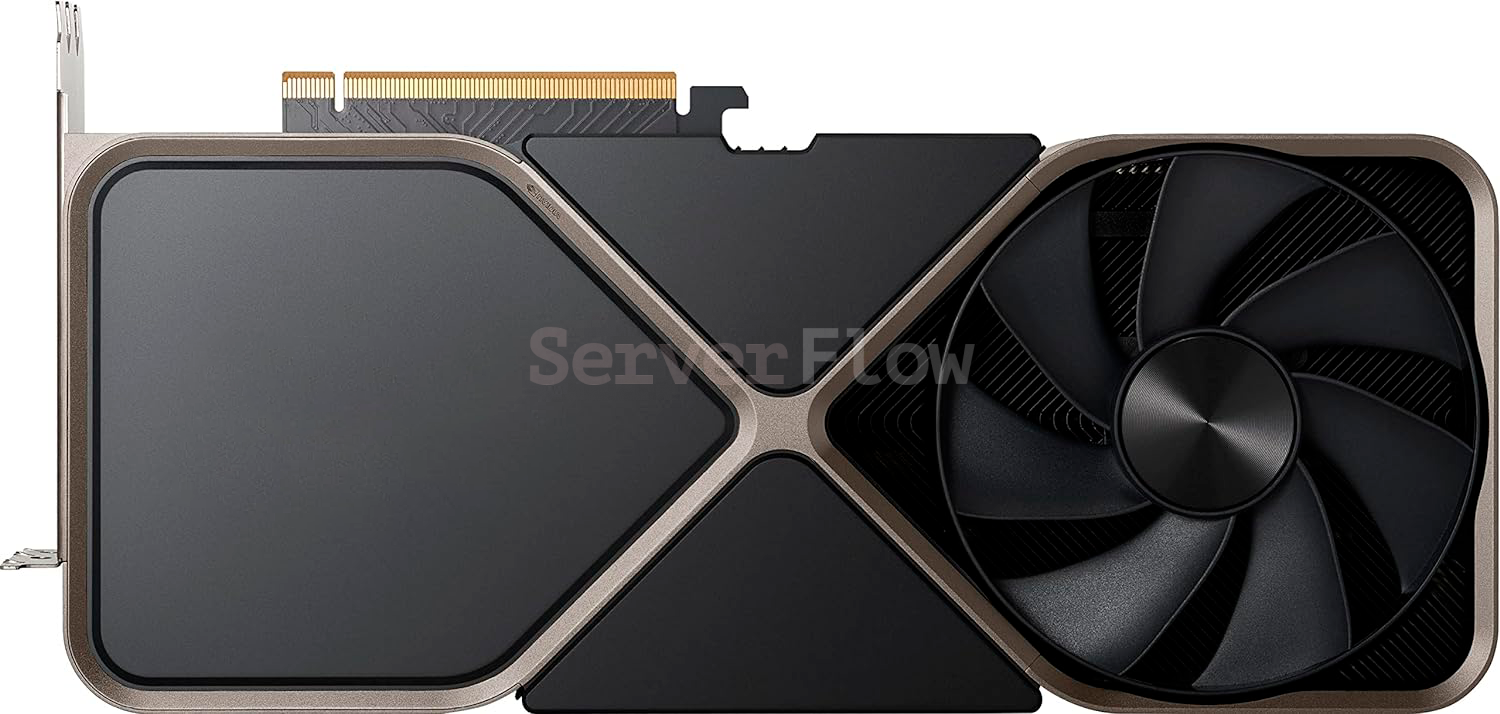

Видеокарты RTX

В случае наличия дополнительного бюджета мы можем рекомендовать к приобретению серию RTX(Quadro), которая построена на базе топовых чипов, а также оборудована двойным объемом видеопамяти:

Видеокарты RTX Quadro

В случае если вам требуется достигнуть максимального объема VRAM в рамках минимального бюджета вы можете использовать ускорители Tesla. За вменяемый бюджет они дают необходимый объем видеопамяти, что может значительно ускорить обучение моделей ИИ:

Видеокарты Tesla

![Видеокарта NVIDIA Tesla P100 16GB HBM2 [900-2H400-0010-000] Видеокарта NVIDIA Tesla P100 16GB HBM2 [900-2H400-0010-000]](/upload/iblock/6c5/7iz2j991wshfig02nvv1lpm09uycx4ts/9c721a3eszw3x17wqgav35l04t1adok0.jpg)

![Видеокарта NVIDIA Tesla P100 16GB HBM2 [900-2H400-0010-000]](/upload/iblock/b41/0f3drz6iikmm57spprgk222ndf0y6j6u/nvidia-tesla-p100-16gb.webp)

![Видеокарта NVIDIA Tesla P100 16GB HBM2 [900-2H400-0010-000]](/upload/iblock/bb1/sa5wf01dy525k8hahyd3wxpz09uss4ch/nvidia-tesla-p100-16gb-pack.webp)

![Видеокарта NVIDIA Tesla P100 16GB HBM2 [900-2H400-0010-000]](/upload/iblock/1ae/xl6ybwsdzclwoiqw6t7n3o413pzil1kx/nvidia-tesla-p100-16gb-back.webp)

![Видеокарта NVIDIA Tesla P40 24GB GDDR5X [900-2G610-0000-000] Видеокарта NVIDIA Tesla P40 24GB GDDR5X [900-2G610-0000-000]](/upload/iblock/a52/5lur7uk3k01xp19titxqanzkehtwwvq4/tesla%20p40.jpg)

![Видеокарта NVIDIA Tesla P40 24GB GDDR5X [900-2G610-0000-000]](/upload/iblock/f31/1ks6t4xrnomfptumvpptytsk5u12h1yk/nvidia-tesla-p40-24gb-backplate.webp)

![Видеокарта NVIDIA Tesla P40 24GB GDDR5X [900-2G610-0000-000]](/upload/iblock/636/7jm63k7lj3qqjup175zfx13fjkhr565s/nvidia-tesla-p40-24gb-2.webp)

![Видеокарта NVIDIA Tesla P40 24GB GDDR5X [900-2G610-0000-000]](/upload/iblock/c74/9ocrsfkvhyk4uprevmdrxr3t60rpwflq/nvidia-tesla-p40-24gb-3.webp)

Корпус

Переходники и адаптеры:

- 7 шт. Гибкий райзер PCI-E 4.0 60см.

- 2 шт. PCI-E X8 to PCI-E X16 адаптер

- Синхронизатор блоков питания

- Кабель SFF8654-8i to 2x U2(SFF8639) 1м

Питание платформы:

Для обеспечения питанием столь нагруженной системы нам предстоит произвести подсчет мощностей. Подсчет будем производить грубо в большую сторону:- Материнская плата, ОЗУ ~ 150W

- Процессор ~ 240W

- Накопители ~ 30W

- Видеокарты ~ 450W * 7 = 3150W

Дополнительные расходы

Несмотря на преимущества установки видеокарт в риг, нередко ускорители ввиду своего крайне высокого TDP перегреваются. Чтобы обеспечить вентиляцию мы рекомендуем установить мощные серверные вентиляторы. Такая практика позволит выдувать горячий воздух и дать картам “дышать”.Итоговая система

После сборки всех компонентов в единый вычислительный комплекс мы имеем отзывчивую систему, где практически все GPU работают на 100% относительно собственных возможностей.| Наименование | Режим работы PCI-E |

| GPU1 | 16 линий 4.0 |

| GPU2 | 16 линий 4.0 |

| GPU3 | 16 линий 4.0 |

| GPU4 | 16 линий 4.0 |

| GPU5 | 8 линий 4.0 |

| GPU6 | 16 линий 4.0 |

| GPU7 | 8 линий 4.0 |

Работа GPU5 и GPU6 в режиме X8 в малой степени скажется на их производительности, поскольку PCI-E 4.0 обладает достаточной пропускной способностью для интенсивной работы GPU в режиме X8.

В зависимости от ваших задач вы можете установить различные OS: Windows Server 2022, Ubuntu Server, Debian, CentOS. Где в последствии, сможете развернуть ваше приложение для работы с AI.

- Сетевой адаптер Mellanox или Intel для работы с высокоскоростным Ethernet соедиенением или Infiniband кластериризированием.

- RAID контроллер для создания аппаратного RAID на SAS HDD, чтобы обеспечить дисковый пул большой емкости для хранения данных.

Недостатки способа сборки:

- Низкая надежность гибких райзеров.

- Трудность транспортировки системы

- Невозможность монтажа таких систем в стойку

Какую систему выбрать. Кастомную или готовую от производителя

Ответ на этот вопрос специалисты ServerFlow видят следующим образом.Если ваша компания не обладает существенными финансами, и вы только начинаете работать с ИИ - приобретайте кастомную систему. Она сохранит ваши средства и станет отправной точной в сферу ИИ.

![Видеокарта NVIDIA RTX A5000 24GB GDDR6 [900-5G132-2200-000] Видеокарта NVIDIA RTX A5000 24GB GDDR6 [900-5G132-2200-000]](/upload/iblock/bc0/01v3ovjqeaxo4h67b8s25fbtzf9os7sh/%D0%92%D0%B8%D0%B4%D0%B5%D0%BE%D0%BA%D0%B0%D1%80%D1%82%D0%B0%20NVIDIA%20RTX%20A5000.jpg)

![Видеокарта NVIDIA RTX A5000 24GB GDDR6 [900-5G132-2200-000]](/upload/iblock/f5c/qqoffk9bj4kiaxw38quzuzk1l8nvsosg/nvidia-rtx-a5000-2.webp)

![Видеокарта NVIDIA RTX A5000 24GB GDDR6 [900-5G132-2200-000]](/upload/iblock/ace/s35cb1sdozlglirblw9kqyukveha8od6/nvidia-rtx-a5000.webp)

![Видеокарта NVIDIA RTX A5000 24GB GDDR6 [900-5G132-2200-000]](/upload/iblock/2a9/0vduwfq3iw4nailckchlvry2hlf3j5h6/nvidia-rtx-a5000-side.webp)

![Видеокарта NVIDIA RTX A6000 48GB GDDR6 [900-5G133-2200-000] Видеокарта NVIDIA RTX A6000 48GB GDDR6 [900-5G133-2200-000]](/upload/iblock/a31/022nhju6uc8wt87ihq06la5z9ex3tr10/videokarta-nvidia-rtx-a6000.png)

![Видеокарта NVIDIA RTX 6000 Ada 48GB GDDR6 [900-5G133-2250-000] Видеокарта NVIDIA RTX 6000 Ada 48GB GDDR6 [900-5G133-2250-000]](/upload/iblock/73d/yds2na053tsmolem42dwcp86x3mbak27/videokarta-nvidia-rtx-6000-ada-generation.jpg)

![Видеокарта NVIDIA Tesla V100 32GB HBM2 [900-2G500-0010-000] Видеокарта NVIDIA Tesla V100 32GB HBM2 [900-2G500-0010-000]](/upload/iblock/3ce/hho6chtf3cnxz6ct2j46os06sxy1vc5s/tesla-v100.png)

![Видеокарта NVIDIA Tesla V100 32GB HBM2 [900-2G500-0010-000]](/upload/iblock/0f3/c62k01e9w74sfqqro7d61v68i0f2xuzd/nvidia-tesla-v100-32gb.webp)

![Видеокарта NVIDIA Tesla V100 32GB HBM2 [900-2G500-0010-000]](/upload/iblock/e70/22m1afanfv0hahm60qrthu38e3gq561p/nvidia-tesla-v100-32gb-cabel.webp)

![Видеокарта NVIDIA Tesla V100 32GB HBM2 [900-2G500-0010-000]](/upload/iblock/ea7/x9gbb4u6ik5jy2o2pmiqf08nuipz1fcn/nvidia-tesla-v100-32gb-2.webp)

![Видеокарта NVIDIA Tesla V100 32GB HBM2 [900-2G500-0010-000]](/upload/iblock/dcb/00wah9bla41zdwvg7fo7stwrylwpfikp/nvidia-tesla-v100-32gb-backplate.webp)

![Видеокарта NVIDIA Tesla V100 32GB HBM2 [900-2G500-0010-000]](/upload/iblock/f8d/eypgm9fp5ftp5bpr9hliu3uox4jar3mg/nvidia-tesla-v100-32gb-part-number-s-n.webp)

![Видеокарта NVIDIA A100 OEM 40GB HBM2 [900-21001-0000-000] Видеокарта NVIDIA A100 OEM 40GB HBM2 [900-21001-0000-000]](/upload/iblock/83b/4254anovicu2b4q1pyx6lei22ccz00d1/nvidia-a100.png)

![Видеокарта NVIDIA A100 OEM 40GB HBM2 [900-21001-0000-000]](/upload/iblock/cf9/pl5mirvwvu85961p0yenfovtr714vchz/videokarta-nvidia-tesla-a100-40gb-kupit.jpg)

![Видеокарта NVIDIA A100 OEM 40GB HBM2 [900-21001-0000-000]](/upload/iblock/0d6/7i616oalfzcj32ucfj5vfi1wrss2lmp5/videokarta-nvidia-tesla-a100-40gb-hbm2e-kupit.jpg)

![Видеокарта NVIDIA A100 OEM 40GB HBM2 [900-21001-0000-000]](/upload/iblock/dc3/x03fb9b9vodh2ej2fv96b250o7tedh03/videokarta-nvidia-tesla-a100-40gb-foto.jpg)

![Видеокарта NVIDIA A100 OEM 40GB HBM2 [900-21001-0000-000]](/upload/iblock/e20/pzpkcc06691t3hcl65h1x8cy6qon3fm7/videokarta-nvidia-tesla-a100-40gb-photo.jpg)